ДИПФЕЙКИ:

новая эпоха в мире технологий или опасное оружие информационной войны?

На протяжении последних лет мы свидетели развития цифровых технологий и их влияния на различные сферы жизни. Одним из самых заметных искусственных инноваций стал дипфейк – технология, позволяющая создавать видео и аудио контент, настолько реалистичный, что может быть принят за настоящий.

Дипфейк расширяет представления о возможностях современной техники и программного обеспечения. Особенность дипфейка в использовании сложных алгоритмов машинного обучения и искуственного интеллекта для исследования и создания материалов. Эта технология позволяет модифицировать данные, полученные от реальных людей, и создавать уникальный контент.

Однако, несмотря на все возможности дипфейка, возникает вопрос этических норм и безопасности. Использованием технологии могут злоупотреблять для создания fake news, подделки доказательств и т.д. Понимание аудиторией различий между реальностью и дипфейком становится все важнее в информационной эпохе.

Дипфейк расширяет представления о возможностях современной техники и программного обеспечения. Особенность дипфейка в использовании сложных алгоритмов машинного обучения и искуственного интеллекта для исследования и создания материалов. Эта технология позволяет модифицировать данные, полученные от реальных людей, и создавать уникальный контент.

Однако, несмотря на все возможности дипфейка, возникает вопрос этических норм и безопасности. Использованием технологии могут злоупотреблять для создания fake news, подделки доказательств и т.д. Понимание аудиторией различий между реальностью и дипфейком становится все важнее в информационной эпохе.

ИСТОРИЯ

Технологии синтезирования видео и аудио нельзя назвать новыми. Они разрабатываются с конца 90-х годов XX века. Конечно, разные попытки делались и до этого, но мы говорим о тех технологиях, которые получили продолжение. Так, в 1997 году компания Video Rewrite представила технологию, которая позволяла сформировать видео, где артикуляция лица совпадала с синтезированной аудиодорожкой, то есть моделировалась артикуляционная мимика лица, которая полностью соответствовала синтезированной компьютером аудиодорожкой.

Достаточно долгое время эти технологии были известны ограниченному кругу специалистов. Но в 2009 году появился «Аватар», который был убедительной демонстрацией таких технологий.

Затем, в 2014 году, юная Одри Хепберн «снялась» в рекламе шоколада - ее лицо было перенесено на лицо актрисы при помощи специализированного ПО.

В 2019 вышел фильм «Ирландец», в котором лица актеров омолодили при помощи ИИ. Фильм подвергли критике, поскольку наложить на лицо 3D-маску недостаточно. Но после обучения ИИ показывает весьма впечатляющие результаты.

Затем, в 2014 году, юная Одри Хепберн «снялась» в рекламе шоколада - ее лицо было перенесено на лицо актрисы при помощи специализированного ПО.

В 2019 вышел фильм «Ирландец», в котором лица актеров омолодили при помощи ИИ. Фильм подвергли критике, поскольку наложить на лицо 3D-маску недостаточно. Но после обучения ИИ показывает весьма впечатляющие результаты.

ВОЗНИКНОВЕНИЕ НАЗВАНИЯ

Технология получила название в 2017 году. Пользователь Reddit создал неприличные видео с лицами знаменитостей. Его никнейм был - Deepfake, это слово решили использовать для обозначения схожих технологий, которые стали очень активно развиваться.

За короткий промежуток времени произошел рост софтверных компаний, предлагающих решения для синтетической генерации видео и аудио - не только людей, но и целых сцен. Каналы YouTube с дипфейками (Shamrock и Ctrl Shift Face) получили большое количество подписчиков.

Простые в использовании приложения deepfake — обычное явление. Индустрия развлечений создает полностью искусственных персонажей, которые становятся известными. Пример - Лил Микела.

За короткий промежуток времени произошел рост софтверных компаний, предлагающих решения для синтетической генерации видео и аудио - не только людей, но и целых сцен. Каналы YouTube с дипфейками (Shamrock и Ctrl Shift Face) получили большое количество подписчиков.

Простые в использовании приложения deepfake — обычное явление. Индустрия развлечений создает полностью искусственных персонажей, которые становятся известными. Пример - Лил Микела.

Локальные и облачные решения предлагают более сложные техноолгии. Synthesia - ведущий поставщик синтетических аватаров, используемых для обучения, обслуживания клиентов, производства видео и многого другого. Пользователи могут выбирать из готового аватара или, после 40-минутного сеанса совместной с сервисом работы, сделать реалистичный эквивалент, сделанный по своему образу и подобию.

Все чаще реалистичная генерация голоса находит применение во всем: работе с клиентами, автоматического перевода и т. п. Примеры игроков из этой сферы - Respeecher и Resemble AI. Первый может изменять голос пользователя на голос другого, управлять его возрастом или переводить на другой язык, в то время как второй позволяет пользователям создавать дипфейки своего собственного голоса.

Все чаще реалистичная генерация голоса находит применение во всем: работе с клиентами, автоматического перевода и т. п. Примеры игроков из этой сферы - Respeecher и Resemble AI. Первый может изменять голос пользователя на голос другого, управлять его возрастом или переводить на другой язык, в то время как второй позволяет пользователям создавать дипфейки своего собственного голоса.

СОВРЕМЕННЫЕ ИГРОКИ

29 октября 2020 года Ким Кардашьян опубликовала видео своего покойного отца Роберта Кардашьян. Лицо Роберта было создано с помощью deepfake. Голограмма была создана компанией Kaleida, которая использовала комбинацию технологий Performance, Motion Tracking, SFX, VFX и DeepFake.

В 2020 году в рамках кампании по безопасности оружия было создано дипфейковое видео Хоакина Оливера, жертвы стрельбы в Паркленде . Родители Оливера в партнерстве с некоммерческой организацией Change the Ref и McCann Health создали видео, в котором Оливер призывает людей поддержать закон о безопасности оружия.

В 2022 году дипфейковое видео Элвиса Пресли было использовано в программе America’s Got Talent 17.

В телевизионной рекламе использовалось фейковое видео участника группы «Битлз» Джона Леннона , убитого в 1980 году.

В 2020 году в рамках кампании по безопасности оружия было создано дипфейковое видео Хоакина Оливера, жертвы стрельбы в Паркленде . Родители Оливера в партнерстве с некоммерческой организацией Change the Ref и McCann Health создали видео, в котором Оливер призывает людей поддержать закон о безопасности оружия.

В 2022 году дипфейковое видео Элвиса Пресли было использовано в программе America’s Got Talent 17.

В телевизионной рекламе использовалось фейковое видео участника группы «Битлз» Джона Леннона , убитого в 1980 году.

ТЕХНИЧЕСКИЕ ПРИЁМЫ

Первые дипфейки заключались в простом «натягивании» лица какой-либо медийной персоны на лицо другого человека с помощью технологии FaceSwap, основанной на генеративно-состязательных сетях (Generative adversarial network, GAN).

GAN состоит из 2 частей: генератора и дискриминатора. Одна модель генерирует реплики из набора образцов изображений, а другая пытается определить, является ли новое изображение фейковым. Когда вторая модель затрудняется ответить, тогда дипфейк достаточно правдоподобен для зрителя. Но технологии шагнули еще дальше и уже сейчас позволяют без специальной аппаратуры создать полноценную цифровую копию человека.

GAN состоит из 2 частей: генератора и дискриминатора. Одна модель генерирует реплики из набора образцов изображений, а другая пытается определить, является ли новое изображение фейковым. Когда вторая модель затрудняется ответить, тогда дипфейк достаточно правдоподобен для зрителя. Но технологии шагнули еще дальше и уже сейчас позволяют без специальной аппаратуры создать полноценную цифровую копию человека.

Последние 20 лет в кинематографе для создания полноценного цифрового клона используется технология CGI (Computer Generated Imagery). Чаще всего она применяется для отрисовки реалистичных анимированных 3D-моделей персонажей, позволяя передавать движения и мимику реального актера 3D-модели с помощью системы меток и высокоскоростных камер.

Также у NVIDIA есть технология, позволяющая анимировать мимику по голосу — Audio2Face. В приложение предварительно загружена «Цифровая метка» — 3D-модель персонажа, которую можно анимировать с помощью звуковой дорожки. Загруженное аудио подается в предварительно обученную глубокую нейронную сеть, которая управляет положением точек 3D-сетки вашего персонажа для создания лицевой анимации в режиме реального времени.

А чтобы озвучить двойника, можно использовать представленную в начале 2023 года ИИ-модель VALL-E от Microsoft, способную клонировать голос человека всего по трехсекундному образцу. Хотя считается, что для качественного синтеза нужно минимум 10 часов студийных записей. VALL-E может воспроизводить не только звук говорящего и его эмоции, но даже среду, в которой он говорит (может воспроизвести телефонный разговор). Комбинация описанных технологий вполне может быть основой для создания цифровых двойников дипфейков.

Также у NVIDIA есть технология, позволяющая анимировать мимику по голосу — Audio2Face. В приложение предварительно загружена «Цифровая метка» — 3D-модель персонажа, которую можно анимировать с помощью звуковой дорожки. Загруженное аудио подается в предварительно обученную глубокую нейронную сеть, которая управляет положением точек 3D-сетки вашего персонажа для создания лицевой анимации в режиме реального времени.

А чтобы озвучить двойника, можно использовать представленную в начале 2023 года ИИ-модель VALL-E от Microsoft, способную клонировать голос человека всего по трехсекундному образцу. Хотя считается, что для качественного синтеза нужно минимум 10 часов студийных записей. VALL-E может воспроизводить не только звук говорящего и его эмоции, но даже среду, в которой он говорит (может воспроизвести телефонный разговор). Комбинация описанных технологий вполне может быть основой для создания цифровых двойников дипфейков.

ИНГРИДИЕНТЫ ДЛЯ ДИПФЕЙКА

С. Дали на «Dali Lives», 2019

Б.Уиллис в рекламе «Мегафон», 2021

А. Лебедев в выпуске на YT, 2021

Рост количества преступлений

с использованием IT-технологий

в России

с использованием IT-технологий

в России

У дипфейков есть ряд заметных признаков, которые позволяют отличить реальность от вымысла. Для создания убедительного дипфейка все нужно правильно комбинировать.

Развитие технологий несет не только позитивные изменения в нашу жизнь, но и дает преступникам новые инструменты для совершения преступлений. Важно принимать меры безопасности и развивать защитные механизмы, чтобы минимизировать угрозы. Так мы сможем эффективно справиться с преступностью.

Об этом же говорит статистика: активное развитие технологий связано с ростом преступлений с их применением. Мы наблюдаем не только улучшение нашего быта и комфорта, но и появление новых возможностей для преступников. На начало 2024 года в России выросло количество случаев использования аудиодипфейков в схеме fake boss («ложный начальник»).

Развитие технологий несет не только позитивные изменения в нашу жизнь, но и дает преступникам новые инструменты для совершения преступлений. Важно принимать меры безопасности и развивать защитные механизмы, чтобы минимизировать угрозы. Так мы сможем эффективно справиться с преступностью.

Об этом же говорит статистика: активное развитие технологий связано с ростом преступлений с их применением. Мы наблюдаем не только улучшение нашего быта и комфорта, но и появление новых возможностей для преступников. На начало 2024 года в России выросло количество случаев использования аудиодипфейков в схеме fake boss («ложный начальник»).

2017

2018

2019

2020

2021

2022

2023

0

100

200

300

400

500

600

700

800

4,4

8,8

14,5

25

25,8

26,5

34,8

тыс. шт.

доля от общего числа преступлений, %

ПРИМЕНЕНИЕ

Техника дипфейка уже успела вызвать огромный ажиотаж и не только заинтересовать широкую общественность, но и проникнуть в различные отрасли в нашей жизни. Помимо развлекательных и художественных целей, дипфейк находит применение и в бизнесе, политике, академической сфере и даже в криминалистике. Технология дипфейка открывает широкий спектр возможностей. Будущее у этой технологии безусловно светло, и мы только начинаем осозновать ее потенциал.

Disney улучшили технологию посредством обучения, запрограммированного на распознавание лица, замены для уточнения данных,что экономит затраты. Модель Диснея может создавать медиафайлы с разрешением 1024 x 1024 (в отличие от обычных 256 x 256). Сначала технология использовалась для неофициальной вставки лиц в существующие медиа, например, наложение лица Харрисона Форда на Хана Соло в «Соло: Истории Звездных войн».

Цифровые клоны профессиональных актеров и раньше появлялись в фильмах , и ожидается, что прогресс в технологии дипфейков повысит доступность и эффективность таких клонов. Использование технологии искусственного интеллекта было серьезной проблемой во время забастовки SAG-AFTRA в 2023 году , поскольку новые методы позволили создавать и хранить цифровые изображения для использования вместо актеров.

Агентство Creative Artists разработало средство для создания образа актера «за один день», а также для разработки цифрового клона актера, который будет контролироваться актером или его имуществом наряду с другими правами личности. Компании, которые использовали цифровые клоны профессиональных актеров в рекламе, включают Puma , Nike и Procter & Gamble.

Цифровые клоны профессиональных актеров и раньше появлялись в фильмах , и ожидается, что прогресс в технологии дипфейков повысит доступность и эффективность таких клонов. Использование технологии искусственного интеллекта было серьезной проблемой во время забастовки SAG-AFTRA в 2023 году , поскольку новые методы позволили создавать и хранить цифровые изображения для использования вместо актеров.

Агентство Creative Artists разработало средство для создания образа актера «за один день», а также для разработки цифрового клона актера, который будет контролироваться актером или его имуществом наряду с другими правами личности. Компании, которые использовали цифровые клоны профессиональных актеров в рекламе, включают Puma , Nike и Procter & Gamble.

АКТЕРСКОЕ МАСТЕРСТВО

В марте 2018 года художник Джозеф Айерле опубликовал видеоработу Un’emozione per semper 2.0. Художник работал с технологией Deepfake для создания ИИ актрисы, синтетической версии кинозвезды 80-х Орнеллы Мути, путешествующей во времени с 1978 по 2018 год. Массачусетский технологический институт включил это произведение в исследование «Коллективная мудрость». Художник исследовал размышления поколений и вопросы о роли провокации в мире искусства. Для технической реализации Айерл использовал кадры с Кендалл Дженнер . Программа заменила лицо Дженнер на рассчитанное ИИ лицо Орнеллы Мути. В результате у лицо итальянской актрисы Орнеллы Мути и тело Кендалл Дженнер.

Дипфейки широко используются в сатире или для пародии на знаменитостей и политиков. Веб-сериал 2020 года «Нахальное правосудие», созданный Треем Паркером и Мэттом Стоуном , широко демонстрирует использование дипфейковых общественных деятелей для высмеивания текущих событий и повышения осведомленности о технологии дипфейков.

Дипфейки широко используются в сатире или для пародии на знаменитостей и политиков. Веб-сериал 2020 года «Нахальное правосудие», созданный Треем Паркером и Мэттом Стоуном , широко демонстрирует использование дипфейковых общественных деятелей для высмеивания текущих событий и повышения осведомленности о технологии дипфейков.

ИСКУССТВО

8 июня 2022 года Дэниел Эммет, бывший участник AGT, объединился со стартапом в области ИИ Metaphysical AI , чтобы создать гиперреалистичный дипфейк, изображающий Саймона Коуэлла. Коуэлл, известный своей резкой критикой участников, на сцене интерпретировал песню «You’re The Inspiration» группы Chicago. Эммет пел на сцене, а образ Саймона Коуэлла появился на экране позади него в безупречной синхронности.

13 сентября 2022 года Metaphysical AI выступила с синтетической версией Элвиса Пресли на финале America’s Got Talent.

Проект ИИ MIT 15.ai использовался для создания контента для множества интернет- фандомов , особенно в социальных сетях.

В 2023 году группы ABBA и KISS объединились с Industrial Light & Magic и Pophouse Entertainment для разработки дипфейковых аватаров, способных давать виртуальные концерты.

13 сентября 2022 года Metaphysical AI выступила с синтетической версией Элвиса Пресли на финале America’s Got Talent.

Проект ИИ MIT 15.ai использовался для создания контента для множества интернет- фандомов , особенно в социальных сетях.

В 2023 году группы ABBA и KISS объединились с Industrial Light & Magic и Pophouse Entertainment для разработки дипфейковых аватаров, способных давать виртуальные концерты.

РАЗВЛЕЧЕНИЯ

МОШЕННИЧЕСТВО

Мошенники используют дипфейки, чтобы обманом заставить людей использовать фальшивые инвестиционные схемы, финансовые махинации, криптовалюты , отправлять деньги. Изображения знаменитостей и политиков использовались для крупномасштабных мошенничеств, а также для целенаправленных фишинговых атак.

По данным Better Business Bureau, мошенничество с дипфейками становится все более распространенным. Во многих рекламных роликах клонирование голоса с помощью ИИ сочетается с «вырванным из контекста видео знаменитости», чтобы имитировать подлинность. Некоторые виды мошенничества могут включать в себя дипфейки в реальном времени.

Аудиодипфейки заставляют людей думать, что они получают инструкции от доверенного лица. В 2019 году генеральный директор британской энергетической компании подвергся мошенничеству по телефону, когда ему приказал перевести 220 000 евро на счет в венгерском банке человек, который использовал технологию аудиодипфейка, чтобы выдать себя за руководителя материнской компании фирмы. Сейчас дипфейки могут клонировать голос человека с записи продолжительностью от нескольких секунд до минуты. Это позволиляет создать убедительный двойник друга или родственника.

По данным Better Business Bureau, мошенничество с дипфейками становится все более распространенным. Во многих рекламных роликах клонирование голоса с помощью ИИ сочетается с «вырванным из контекста видео знаменитости», чтобы имитировать подлинность. Некоторые виды мошенничества могут включать в себя дипфейки в реальном времени.

Аудиодипфейки заставляют людей думать, что они получают инструкции от доверенного лица. В 2019 году генеральный директор британской энергетической компании подвергся мошенничеству по телефону, когда ему приказал перевести 220 000 евро на счет в венгерском банке человек, который использовал технологию аудиодипфейка, чтобы выдать себя за руководителя материнской компании фирмы. Сейчас дипфейки могут клонировать голос человека с записи продолжительностью от нескольких секунд до минуты. Это позволиляет создать убедительный двойник друга или родственника.

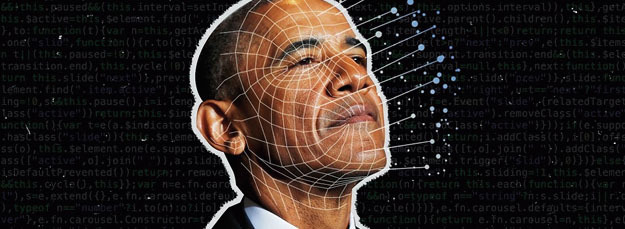

Дипфейки использовались для искажения изображения известных политиков в видеороликах. Одним из первых политических дипфейков был дипфейк с Бараком Обамой. В апреле 2018 года Джордан Пил в сотрудничестве с Buzzfeed создал дипфейк Барака Обамы с голосом Пила; он служил общественным объявлением, призванным повысить осведомленность о дипфейках.

Дипфейки в политике - это явление, которое становится все более распространенным в нашем мире. В эпохе информационных технологий и социальных сетей, дипфейки представляют собой манипулятивное использование фальшивой информации с целью влияния на общественное мнение, формирования определенных политических предпочтений и достижения собственной выгоды.

Дипфейки в политике - это явление, которое становится все более распространенным в нашем мире. В эпохе информационных технологий и социальных сетей, дипфейки представляют собой манипулятивное использование фальшивой информации с целью влияния на общественное мнение, формирования определенных политических предпочтений и достижения собственной выгоды.

ПОЛИТИКА

Использованы информационные ресурсы:

https://www.ispring.ru/elearning-insights/dipfejk

https://trends.rbc.ru/trends/industry/637738a09a79478e6797b557

http://www.sberbank.ru/ru/person/kibrary/articles/deepfake-kak-raspoznat-i-kak-zashchititsya

https://encyclopedia.kaspersky.ru/glossary/deepfake/

https://www.kaspersky.ru/blog/audio-deepfake-technology/35694/

https://gb.ru/blog/chto-takoe-dipfejk/

https://www.ispring.ru/elearning-insights/dipfejk

https://trends.rbc.ru/trends/industry/637738a09a79478e6797b557

http://www.sberbank.ru/ru/person/kibrary/articles/deepfake-kak-raspoznat-i-kak-zashchititsya

https://encyclopedia.kaspersky.ru/glossary/deepfake/

https://www.kaspersky.ru/blog/audio-deepfake-technology/35694/

https://gb.ru/blog/chto-takoe-dipfejk/